Augmenting wearable sensor data for sign language recognition

Bachelorarbeit

Motivation

Weltweit gibt es circa 466 Millionen Menschen mit einer Hörbehinderung. 72 Millionen von ihnen, das entspricht in etwa 1 % der Weltbevölkerung, nutzen eine von über 300 Gebärdensprachen.

Zur besseren Kommunikation kann Gebärdensprache in Lautsprache übersetzen werden. Dazu wird aktuell immer ein Gebärdendolmetscher benötigt. Eine technische Lösung wäre wünschenswert, birgt aber aufgrund der Komplexität der Gebärden einige Herausforderungen. Eine dieser Herausforderungen ist die Klassifizeriung der charakteristischen Merkmale von Gebärden, wie beispielsweise Handform oder Bewegung der Hand.

Für eine hohe Genauigkeit des Klassifizierers muss dieser mit einer hohen Quantität – aber auch Qualität – von Daten trainiert werden. Gerade die Aufnahme dieser Daten ist aber nicht trivial, da sie idealerweise von vielen unterschiedlichen Personen stammen sollten. Um eine Datenaufnahme mit einer hohen Anzahl an Probanden durchzuführen ist jedoch ein hoher zeitlicher und organisatorischer Aufwand notwendig. Die Corona-Pandemie erschwert diese Aufnahme zusätzlich.

Aufgaben

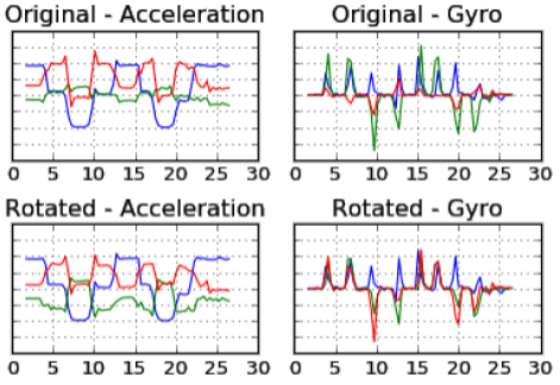

In dieser Arbeit sollen verschiedene Methoden zur Data Augmentation von durch Wearables aufgenommene Daten im Kontext einer Gebärdesprachenerkennung implementiert und deren Ergebnisse verglichen werden. Hierbei sollen sowohl physikalische als auch anatomische Einschränkungen ermittelt und berücksichtigt werden.

Es soll eine Einschätzung zur Generalisierbarkeit des Ansatzes bzw. dessen Adaption auf ähnliche Sensordaten gegeben werden.

Anforderungen

- Erfahrung mit Python oder C++

Keywords

Machine Learning, Gesture recognition, Data augmentation, Sign Language